Zagrożenia dezinformacyjne w erze sztucznej inteligencji – inwazja deepfake’ów

W dobie szybkiego postępu technologii sztuczna inteligencja (AI) stała się narzędziem zarówno do tworzenia, jak i zwalczania dezinformacji.

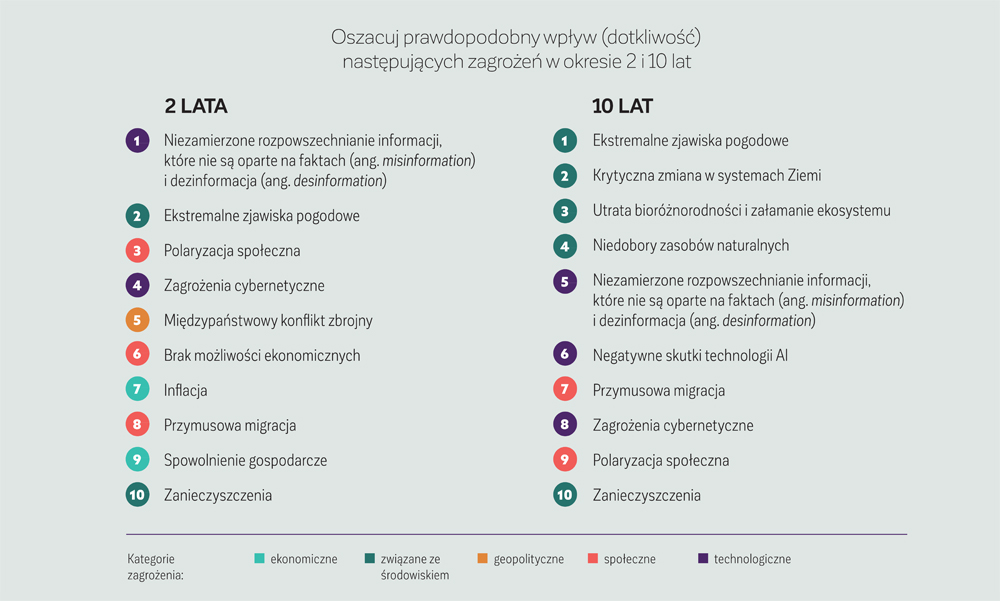

Według raportu „Global Risks Report 2024”, opracowanego przez Światowe Forum Ekonomiczne (WEF) we współpracy z Zurich Insurance Group oraz Marsh McLennan i analizującego najpoważniejsze zagrożenia dla świata w ciągu najbliższej dekady, głównie należy obawiać się kryzysu kosztów utrzymania oraz ryzyka dezinformacji napędzanej sztuczną inteligencją.

Obok przedstawiano zestawienie z raportu WEF, które ukazuje najważniejsze rodzaje ryzyka, z jakimi będziemy musieli się zmierzyć zarówno w perspektywie krótko-, jak i długoterminowej.

Umieszczenie na pierwszym miejscu dezinformacji (działanie intencjonalne) i „misinformacji” (działanie nieintencjonalne) może mieć fundamentalne znaczenie dla obecnej sytuacji geo-

politycznej. Rok 2024 był „rokiem wielkich wyborów”, różnego rodzaju wybory miały miejsce w aż 70 krajach świata, gdzie głos mogło oddać aż 4,2 mld ludzi, czyli ponad połowa populacji na świecie. Zwiększyło to jeszcze obawy związane z dezinformacją oraz jej wpływem na społeczeństwa, stąd też nie dziwi pozycja lidera (#1) – „misinformacji” i dezinformacji w rankingu dziesięciu najważniejszych zagrożeń w 2024 r.

Kreowanie nieprawdziwych treści nie wymaga obecnie specjalistycznych umiejętności, a łatwe w użyciu interfejsy do dużych modeli AI umożliwiają wręcz eksplozję fałszywych informacji i tzw. syntetycznych treści, od zaawansowanego klonowania głosu, wygenerowania klonów, po fałszywe strony internetowe.

CZYM WŁAŚCIWIE JEST DEZINFORMACJA?

Dezinformacja to fałszywy przekaz informacyjny zawierający treści, stwierdzenia lub przekazy audiowizualne niezgodne z rzeczywistością. W odróżnieniu od „misinformacji” dezinformacja to działanie celowe, co oznacza, że zawsze stoją za nią osoby lub podmioty, a ich intencją jest wywarcie zamierzonego przez siebie wpływu na innych. Mogą one wpływać na zmianę opinii, decyzji czy też ugruntowanie określonego światopoglądu. Działania dezinformujące są zjawiskiem negatywnym i społecznie szkodliwym. Obiekt dezinformacji jest przedmiotem manipulacji informacyjnej i w konsekwencji staje się jej ofiarą. „Misinformacja” z kolei nie jest działaniem intencjonalnym. Są to fałszywe lub wprowadzające w błąd treści udostępniane bez złych intencji, chociaż skutki ich rozpowszechniania mogą być nadal szkodliwe.

Dezinformacja nie jest niczym nowym, zjawisko to jest mocno zakorzenione w społeczeństwie oraz obecne w nim praktycznie od samego początku istnienia. Natomiast w dobie rozwoju technologii, a zwłaszcza sztucznej inteligencji i masowości mediów, dezinformacja stała się szczególnie niebezpiecznym zjawiskiem, bowiem jeszcze nigdy wcześniej tworzenie i rozpowszechnianie tego rodzaju informacji nie było tak łatwe. W konsekwencji możliwość wpływu na opinie i decyzje podejmowane zarówno przez jednostki, jak i ogół społeczeństwa stała się dość łatwa.

Narzędziami kampanii dezinformacyjnej mogą być w szczególności deepfake’i, które są ogromnym zagrożeniem nie tylko dla pojedynczych osób, ale też mogą stanowić zagrożenie na globalną skalę.

WYKRES 1: 10 największych zagrożeń

Źródło: Globalne badanie percepcji ryzyka Światowego Forum Ekonomicznego w latach 2023-2024

DEEPFAKE’I JAKO NARZĘDZIE WYKORZYSTYWANE W DZIAŁANIACH DEZINFORMACYJNYCH

Termin „deepfake” wywodzi się od pseudonimu użytkownika, który w 2017 r. opublikował w internecie fałszywe wideo (o treści pornograficznej) z wizerunkami celebrytów, posługując się pseudonimem „deepfakes”. Technologia deepfake’ów wykorzystuje moc głębokiego uczenia do tworzenia fałszywych treści audio i audiowizualnych. To zaawansowana technologia manipulacji przy użyciu AI.

Pierwotnie terminem „deepfake” nazywano jedynie zamianę twarzy na materiałach wideo lub obrazie (ang. face swap), jednak z czasem rozszerzono znaczenie tego słowa o inne manipulacje. I tak obecnie można wyróżnić:

- edycję atrybutów (ang. attribute editing) – zmiana cech charakterystycznych osoby,

- odwzorowanie twarzy (ang. face reenactment) – przeniesienie ekspresji mimicznej z twarzy jednej osoby na osobę w docelowym filmie wideo,

- w pełni syntetyczny materiał (ang. fully synthetic material) – prawdziwy materiał filmowy jest używany do treningu oprogramowania, ale materiał wynikowy jest całkowicie nowy.

Deepfake’i są coraz bardziej popularne, są też coraz trudniejsze do odróżnienia od prawdziwych treści. Wynika to z doskonalącej się technologii, lepiej naśladującej ruch i gesty ludzkie oraz lepiej dopasowującej warstwę dźwiękową do wizualnej. Deepfake’i mogą być wykorzystywane w pożytecznych celach, np. jako filmy edukacyjne z postaciami ze świata kultury lub sztuki (żyjącymi lub też historycznymi), które w ciekawy sposób przekazują informacje, czy w starych filmach do odświeżenia i restauracji starych, uszkodzonych lub niekompletnych materiałów filmowych, przywracając im pierwotny blask. Częściej jednak technologia deepfake’ów wykorzystywana jest do dezinformacji i dyskredytacji celem wprowadzenia zamętu czy też wykorzystywania czyjegoś wizerunku do jego kompromitacji. Bywa też narzędziem hakerów, szantażystów i trolli internetowych.

Deepfake’i to realne zagrożenie dla każdego z nas. Raport „Złośliwe wykorzystanie i nadużycia sztucznej inteligencji” (Malicious Uses and Abuses of Artificial Intelligence), opracowany przez Europol, TrendMicro i UNICRI, zawiera studium przypadku na ten temat. Wskazuje on m.in., że technologia deepfake’ów może ułatwiać w szczególności następujące działania przestępcze:

- nękanie lub upokarzanie osób online,

- przeprowadzanie szantażu i oszustw,

- ułatwianie fałszowania dokumentów,

- tworzenie fałszywych tożsamości online i oszukiwanie mechanizmów „poznaj swojego klienta” (AML),

- nielegalna pornografia,

- zakłócanie rynków finansowych,

- rozpowszechnianie dezinformacji i manipulowanie opinią publiczną,

- wspieranie narracji ekstremistycznych lub organizacji terrorystycznych,

- podsycanie niepokoi społecznych i polaryzacji politycznych.

Deepfake’i są również szczególnie groźnym narzędziem do wykorzystania w ramach działań nieuczciwej konkurencji czy też w działaniach militarnych, wzbudzając masową panikę. To spory zakres i nie jest to katalog zamknięty, co utwierdza obawy związane z funkcjonowaniem w świecie, w którym przekaz informacyjny można tak łatwo zmanipulować i upowszechnić oraz wykorzystać do niewłaściwych celów.

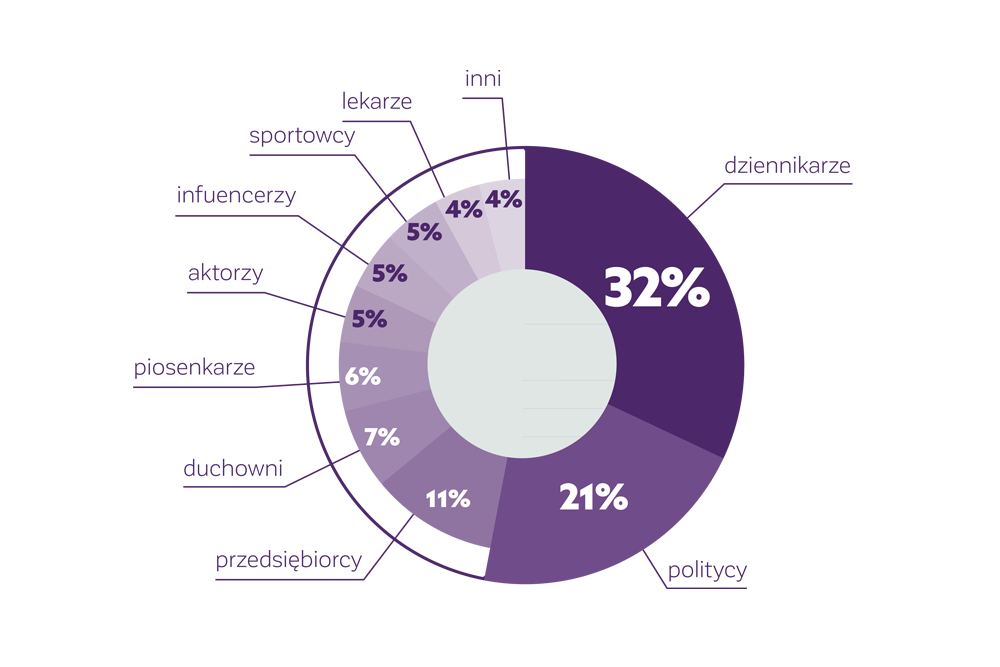

WYKRES 2: Grupy społeczne wykorzystywane do oszustw deepfake

Źródło: NASK

PRZYKŁADY WYKORZYSTANIA DEEPFEKE’ÓW W RAMACH DZIAŁAŃ DEZINFORMACYJNYCH

Deepfake jako zagrożenie dla demokracji i wyborów

Deefeke’i mogą być szczególnie niebezpiecznym narzędziem do wykorzystania w kampaniach wyborczych. Według opublikowanego w kwietniu 2024 r. raportu firmy Check Point, która przeanalizowała 36 procesów wyborczych (parlamentarnych, prezydenckich i lokalnych) na całym świecie z ostatniego pół roku, do manipulacji treścią informacji i przekazów medialnych z wykorzystaniem technologii deefake’ów doszło w dziesięciu krajach. Niestety na niechlubnej „czarnej liście” znalazła się również Polska za sprawą wykorzystania w kampanii wyborczej syntetycznego materiału – deepfake'u – stworzonego przy użyciu AI. W raporcie znalazła się też Słowacja w związku ze sfałszowanym przedwyborczym klipem audio, w którym Michal Szimeczka, szef partii opozycyjnej Postępowa Słowacja, mówi o planach „zakupu głosów” od wyborców pochodzenia romskiego. Materiał ten szybko rozprzestrzenił się w internecie. W Argentynie zaś w czasie wyborów prezydenckich obaj kandydaci tworzyli fałszywe zdjęcia z użyciem AI. Z kolei w Indiach dzięki AI „wskrzeszono” Muthuvela Karunanidhiego, dawno zmarłego przywódcę partii DMK, który w wygenerowanym materiale wideo komplementował obecnych liderów ugrupowania. Podobne przypadki odnotowano też w Indonezji.

Jeśli chodzi o przykłady wykorzystania deepfeke’ów w ramach kampanii wyborczej do Parlamentu Europejskiego można wymienić przypadek Francji i nagranie umieszczone na platformie TikTok, w którym rzekome siostrzenice skrajnie prawicowej populistki Marine Le Pen reklamowały jej partię Zjednoczenie Narodowe. „Siostrzenice” Amandine Le Pen i Lena Maréchal tak naprawdę nie istnieją, zostały stworzone przy pomocy AI. Zostało to odkryte i nagłośnione we francuskiej prasie i na TikTok-u. W tym przypadku celem była kreacja wizerunku skrajnej prawicy w wyborach europejskich jako popieranej przez ludzi młodych i atrakcyjnych.

W tym roku możemy być świadkami kolejnych prób manipulacji opinią publiczną podczas kampanii wyborczych. Jak czytamy w artykule Polskie wybory prezydenckie 2025 celem ataku hakerów z Rosji opublikowanym w serwisie eGospodarka.pl: „Jest wielce prawdopodobne, że niemieckie wybory federalne w lutym 2025 r. oraz polskie wybory prezydenckie w maju 2025 r. staną się celem rosyjskiej dezinformacji. Działania dezinformacyjne prawdopodobnie wykorzystają istniejące podziały społeczne, aby podważyć poparcie dla Ukrainy i kształtować opinię publiczną. Dodatkowo, Rosja może także sięgnąć po fizyczne sabotaże w połączeniu z działaniami dezinformacyjnymi. Należy spodziewać się, że rosyjskie grupy NoName lub APT będą prowadzić cyberwywiad, mający na celu identyfikację potencjalnych zmian politycznych i osób sprzyjających rosyjskim interesom. Niepokojącym sygnałem jest również najnowsza (15.01.2025) informacja o stworzeniu sojuszu przez grupę hakerów rosyjskich NoName z French Hackers Squad. Organizacje te ostatnio atakowały Litwę, Polskę, Kanadę, Ukrainę, Włochy i Niemcy”.

Check Point Research wskazuje: W Polsce hakerzy obrali za cel głównie sektor użyteczności publicznej oraz wojskowo-rządowy, które atakowane było odpowiednio 2063 i 2058 razy w skali miesiąca – to poziom porównywalny z sąsiednimi Czechami i Węgrami (2 200), znacznie wyższy niż na Słowacji (1 400) czy w Niemczech (1 300). Dane te plasują Polskę w ścisłej czołówce państw Europy Środkowej pod względem liczby ataków na sektor rządowo-wojskowy.

Deepfake jako oszustwo w działalności biznesowej

Jeśli chodzi o obszar biznesu, to wartym przytoczenia jest przypadek pracownika międzynarodowej firmy, który przelał pieniądze na konto oszustów po wideokonferencji ze sztucznie wygenerowanym obrazem dyrektora finansowego. Mężczyzna najpierw otrzymał od osoby, która twierdziła, że jest dyrektorem finansowym firmy z siedzibą w Wielkiej Brytanii, maila z poleceniem wykonania przelewu na kwotę 200 mln dolarów hongkońskich, czyli około 25,6 mln USD. Pracownik podejrzewał, że jest to próba pishingu. W kolejnym mailu dostał on link do spotkania z innymi pracownikami oraz dyrektorem finansowym. Podczas wideokonferencji w obecności świadków dyrektor powtórzył polecenie wykonania przelewu. Nic nie wzbudziło podejrzenia mężczyzny. Dyrektor i inni pracownicy, których znał, wyglądali i zachowywali się normalnie. Dlatego przelał całą kwotę na wskazane konto. Dopiero po czasie okazało się, że spotkanie było przygotowane przez oszustów, a jego uczestnicy mieli cyfrowo wygenerowany wygląd i głos innych osób. Zdaniem funkcjonariuszy wykorzystano do tego publicznie dostępne nagrania wideo i audio. Policja nie ujawniła nazwy firmy.

Deepfake jako narzędzie destabilizacji sytuacji geopolitycznej

Jako najgroźniejsze do tej pory przykłady użycia deepfake’ów wskazuje się te wygenerowane w czasie wojny w Ukrainie. Zaledwie trzy tygodnie od rosyjskiej inwazji pojawiło się nagranie z prezydentem Wołodymyrem Zełenskim, rzekomo nawołującym do złożenia broni. W krótkim czasie wyemitowano też wideo, na którym widać rzekomego prezydenta Rosji Władimira Putina, który ogłasza porozumienie pokojowe. Ukraina szybko zdementowała fałszywy przekaz, natomiast nagrania te osiągnęły gigantyczne zasięgi.

DEEPFAKE’I W POLSCE

W lipcu 2024 r. Naukowa i Akademicka Sieć Komputerowa – Państwowy Instytu Badawczy (NASK) opublikował na swojej stronie internetowej listę osób, których wizerunki od początku tego roku zostały wykorzystane do przeróbek typu deepfake w oszustwach adresowanych do użytkowników polskiej przestrzeni internetowej, odnotowanych na platformach społecznościowych Facebook, TikTok, X oraz YouTube. Na liście tej znalazło się 121 osób.

Jak informuje NASK, grupą najbardziej narażoną na kradzież wizerunku i głosu, zgodnie z danymi zebranymi przez ekspertów NASK i KNF (Komisji Nadzoru Finansowego – red.), są dziennikarze – to aż 32% poszkodowanych osób. Są to m.in. oszustwa, w których dziennikarka lub dziennikarz sztucznie stworzonym „swoim” głosem wraz z dopasowanym do fałszywego komunikatu ruchem ust (technika lip-sync) namawiają do inwestycji finansowej czy też „cudownego lekarstwa”. W większości jednak przypadków towarzyszą na przerobionych przez przestępców filmach innym znanym postaciom, zwykle ze świata polityki. Wywiad z wykorzystaniem studia dużej stacji radiowej czy telewizyjnej to dodatkowy element, który wzmacnia wiarygodność przekazu oszustów.

Kolejną grupą z najwyższym odsetkiem poszkodowanych kradzieżą wizerunku są politycy (21%) i biznesmeni (11%), reklamujący fałszywe inwestycje, do których oszustwa typu deepfake są najczęściej wykorzystywane. Lukratywne projekty czy platformy finansowe uwiarygadniane są również poprzez manipulacje wizerunkami influencerów (5%) i sportowców (5%). Wizerunki duchownych (7%) oraz lekarzy (4%) służą zwykle przestępcom do preparowania oszustw „cudownych lekarstw”. Wiarygodność tej odmiany kradzieży również bywa wzmacniana wizerunkami polityków, a także piosenkarzy czy aktorów.

W powszechnym przekonaniu walka z deep-fake'ami to przysłowiowa walka Don Kichota z wiatrakami. Sukcesy w tym obszarze nie są zbyt częste, ani też spektakularne, dlatego też tak wartym odnotowania oraz dalszego śledzenia rozwoju wydarzeń są decyzje wydane przez Prezesa Urzędu Ochrony Danych Osobowych (PUODO) Mirosława Wróblewskiego zobowiązujące firmę Meta do wstrzymania wyświetlania w Polsce na Facebooku i Instagramie reklam wykorzystujących prawdziwe dane oraz wizerunek dziennikarki i prezenterki Omeny Mensah oraz biznesmena Rafała Brzoski. Jest to decyzja przełomowa, ponieważ po raz pierwszy w Polsce podmiot z branży Big Tech otrzymał zakaz wyświetlania informacji z wizerunkiem osoby fizycznej. Decyzje te są konsekwencją skarg wniesionych przez Mensah i Brzoskę w związku z fałszywymi informacjami, które pojawiły się na Facebooku, dotyczącymi śmierci dziennikarki, pobicia przez męża czy trafienia przez nią do więzienia oraz deepfake’owymi reklamami, w których zostały wykorzystane prawdziwe, aktualne dane osobowe zarówno dziennikarki, jak i biznesmena. Przedsiębiorca pojawił się w deepfake’owej reklamie w serwisach Facebook i Instagram; miał on rzekomo założyć platformę, która zapewnia zyski wszystkim „obywatelom Polski”. Meta rozpowszechniała nagrania bez weryfikacji i oceny wiarygodności danych osobowych. W ocenie PUODO zostało w pełni uprawdopodobnione, że doszło do naruszenia przez Meta przepisów o ochronie danych. Meta naruszyła także Kartę praw podstawowych UE, ponieważ godność człowieka jest nienaruszalna i musi być chroniona.

Prezes UODO, reagując na ww. skargi, skorzystał z przepisu art. 66 ust. 1 RODO, który w wyjątkowych okolicznościach pozwala mu zastosować środek tymczasowy jeśli uzna, że istnieje pilna potrzeba ochrony praw i wolności osób, których dane dotyczą. Zakaz obowiązuje przez trzy miesiące. Prezes UODO, zgodnie z procedurą, powiadomił o tym pozostałe organy nadzorcze, których sprawa dotyczy, a także Europejską Radę Ochrony Danych i Komisję Europejską. Pozostaje także w bezpośrednim kontakcie z wiodącym organem nadzorczym, tj. organem irlandzkim. Skargi będą rozpatrywane przez organ irlandzki, bo tam ma siedzibę Meta Platforms Ireland Limited.

Założyciel InPostu wraz z Omeną Mensah złożyli również pozew w polskim sądzie, wnioskując m.in. o naliczanie kar finansowych za każdy przypadek używania przez Metę ich wizerunku bez ich zgody. Jak wynika z publicznej informacji, udostępnionej przez Rafała Brzoskę: „złożyliśmy pozew w polskim sądzie! Wnioskowaliśmy również o naliczanie kar finansowych za każdy kolejny przypadek używania przez Metę naszego wizerunku bez naszej zgody i braniu przez nich de facto udziału w przestępstwie (zatwierdzają i publikują odpłatnie reklamy z deepfake’ami). Sąd podzielił nasze stanowisko w pełni i wydał postanowienie o udzieleniu zabezpieczenia na okres jednego roku. (WAŻNE! Jest to maksymalny czas w sprawach o ochronę dóbr osobistych)”1. Postanowienie to jest krokiem w stronę odpowiedzialności dużych platform za publikowane treści.

Dalsze decyzje w tej sprawie mogą być przełomowe, na pewno przypadek ten wskazuje na konieczność pilnej potrzeby wprowadzenia odpowiednich regulacji zobowiązujących platformy społecznościowe do wprowadzania skuteczniejszych mechanizmów identyfikacji i usuwania fake newsów. Cel zacny i konieczny, natomiast jest też z tym związane ryzyko, ponieważ demokracja nie może istnieć bez wolności słowa, musimy szczególnie uważać na wszelkie działania, które mogą ją ograniczać. Wydaje się, że wszyscy zgadzamy się co do tego, że nie powinniśmy zezwalać na udostępnianie nielegalnych treści w internecie, ale łatwiej powiedzieć niż zrobić. Zobaczymy, co przyniesie przyszłość i czy przypadek Omeny Mensah i Rafała Brzoski przyczyni się do podjęcia szybszych działań w tym zakresie.

A JAK WYGLĄDA DEZINFORMACJA W OPINII POLAKÓW?

Dezinformacja stała się kluczowym narzędziem w rękach osób i organizacji, które próbują wpłynąć na opinię publiczną, mogąc w ten sposób destabilizować sytuację społeczną i polityczną. Niewątpliwie dynamiczny postęp technologiczny oraz ogólny dostęp do internetu wpływa na szybkość rozpowszechnianych informacji. Jak wynika z danych „Forbes” za firmą badawczą Statista, niemal 66% światowej populacji korzysta z sieci internet. Z kolei dostęp do mediów społecznościowych, według agencji Smart Insight, posiada 62% światowej populacji. Nie dziwi zatem, że informacje mogą rozprzestrzeniać się w krótkim czasie z szybkością na niespotykaną dotychczas skalę.

Według badań Envisage Digital każdego dnia publikowanych było około 4,4 mln postów na wszystkich platformach, w tym blogach internetowych (dane za rok 2022). Ogromna ilość danych nie pozwala na ich wnikliwą analizę, a fałszywych informacji przybywa z roku na rok. Potwierdzają to również badania.

Z raportu „Dezinformacja oczami Polaków 2024”, opracowanego przez Koalicję „Razem Przeciw Dezinformacji”, wynika, że 84% Polaków spotkało się z fałszywymi informacjami. Oznacza to wzrost o 2 pp. względem 2021 r. Najczęstszym źródłem fałszywych informacji są media społecznościowe (55%), telewizja (53%) oraz przekazy polityków (52%). Co drugi Polak (59%) otrzymał fake newsa od innych osób, głównie poprzez przekaz ustny, np. w rozmowie z rodziną i znajomymi (57%) oraz poprzez media społecznościowe (49%). Niemal 3/4 ankietowanych (73%) uważa, że celem fake newsów jest manipulacja opinią publiczną. Ponadto większość Polaków (86%) popiera oznaczanie treści generowanych przez sztuczną inteligencję. Ponad połowa ankietowanych (58%) oczekuje działań ograniczających dezinformację po stronie samych platform internetowych, nawet kosztem wolności słowa. Ponad połowa Polaków oczekuje, że rząd powinien podjąć działania ograniczające rozprzestrzenianie fałszywych informacji, nawet jeśli te działania ingerowałyby w wolność słowa (51%).

Dane z raportu wskazują, że dezinformacja dotyka ogromu Polaków, ujawniają też wysoką świadomość Polaków w tym obszarze oraz na oczekiwania znacznej ich części na podjęcie działań ograniczających rozprzestrzenianie się fałszywych informacji zarówno przez platformy internetowe, jak i rząd, nawet jeśli byłoby to kosztem ingerencji w wolność słowa.

JAK WALCZYĆ Z DEZINFORMACJĄ – UWAGI KOŃCOWE

Komisja Europejska we wrześniu 2018 r. opublikowała Kodeks postępowania w zakresie zwalczania dezinformacji. W czerwcu 2022 r. został opublikowany i podpisany tzw. wzmocniony kodeks (po przeglądzie). Przystąpienie do kodeksu jest dobrowolne, a jego sygnatariuszami są największe firmy internetowe (m.in. Facebook, Google, Microsoft, TikTok, Twitter), jak również organizacje branżowe. Sankcją za naruszenie przepisów jest wykluczenie danego podmiotu jako jego sygnatariusza, przy czym to jedyna sankcja przewidziana w kodeksie z tytułu jego nieprzestrzegania.

W Polsce w chwili obecnej brak jest jednego aktu prawnego wprowadzającego środki prawne zwalczania dezinformacji, co nie oznacza, że jesteśmy w tym zakresie pozbawieni jakichkolwiek możliwości. Zastosowanie tutaj mają przepisy ustaw z kilku obszarów.

Jeśli natomiast chodzi deepfake’i, to choć sam deepfake jako zjawisko nie został uznany za sprzeczny z prawem, w rzeczywistości manipulacja dźwiękiem, obrazem lub animacją może doprowadzić do popełnienia czynu sprzecznego z ustawą i może wiązać się z naruszeniem oraz odpowiedzialnością w następujących obszarach:

- naruszenie praw osobistych – możliwość naruszenia prawa do wizerunku lub głosu czy też dobrego imienia lub czci osoby fizycznej, chronionego jako dobro osobiste na gruncie przepisów kodeksu cywilnego,

- naruszenie praw autorskich – deepfake może prowadzić do naruszenia praw autorskich przysługujących określonemu utworowi; karalne jest samo wykorzystanie utworu bez zgody twórcy, ale także jego modyfikacja,

- deepfake a nieuczciwe praktyki rynkowe – ustawa o przeciwdziałaniu nieuczciwym praktykom rynkowym przewiduje kary dla przedsiębiorców, którzy wprowadzają konsumentów w błąd, skłaniając ich do decyzji, których normalnie by nie podjęli.

W takich przypadkach przedsiębiorca musi liczyć się z odpowiedzialnością cywilną, w tym z odszkodowaniem, unieważnieniem zawartej umowy lub zaniechaniem praktyki, np. poprzez usunięcie z mediów społecznościowych całej kampanii reklamowej.

Deepfake a nieuczciwa konkurencja – również ustawa o zwalczaniu nieuczciwej konkurencji przewiduje kary zarówno w zakresie odpowiedzialności cywilnej, jak i karnej dla przedsiębiorców za działania sprzeczne z prawem lub dobrymi obyczajami, jeżeli zagrażają oni innemu przedsiębiorcy lub naruszają interes innego przedsiebiorcy czy klienta (czyny nieuczciwej konkurencji).

Deepfake’i mogą również stanowić narzędzia wykorzystywane w ramach działań przestępczych; odpowiedzialność w tym zakresie wiąże się z danym czynem zabronionym oraz przewidzianą z tego tytuły sankcją karną.

Odnośnie do regulacji, które nakładają obowiązek konkretnych działań/zachowań w związku z deepfake’ami, należy wskazać m.in.:

- Rozporządzenie UE – akt w sprawie sztucznej inteligencji, które nakłada na podmioty stosujące system AI (generujący obrazy, treści audio lub wideo stanowiące treści deepfake lub manipulujący takimi obrazami lub treściami), obowiązek ujawnienia, że treści te zostały sztucznie wygenerowane lub zmanipulowane (począwszy od 2 sierpnia 2026 r.). Z treści przepisu nie wynika sposób, w jaki ma zostać oznaczony materiał. Należy jednak przypuszczać, że powinno to nastąpić w sposób wyraźny i jednoznaczny.

- Rozporządzenie w sprawie jednolitego rynku usług cyfrowych (ang. Digital Services Act, DSA) nakłada na podmioty VLOP (ang. very large online platform) oraz VLOSE (ang. very large online search engine), czyli kolejno bardzo duże platformy internetowe i bardzo duże wyszukiwarki internetowe, obowiązek wprowadzenia mechanizmów zmniejszenia ryzyka i zarządzania nim. Jednym z jego elementów – zgodnie z art. 35 ust. 1 pkt k – jest analiza zamieszczanych w serwisie treści pod kątem deepfake’ów. Przepis nakłada obowiązek, aby każdą informację, w tym deepfake, można było rozróżnić dzięki widocznym oznaczeniom, gdy prezentuje się ją na interfejsach internetowych.

Przy czym podstawowym środkiem zapobiegawczym i ochronnym jest umiejętność krytycznego myślenia oraz zasada ograniczonego zaufania do tego, co słyszymy oraz widzimy, co oczywiście nie jest łatwe. Wraz z rozwojem technologii deepfake’ów rozwijają się także narzędzia i techniki zaprojektowane do ich wykrywania. Warto odnotować, że również w Polsce trwają prace nad aplikacją do walki z deepfake’ami. Naukowcy z ośrodka badawczo-rozwojowego IDEAS NCBR opracowali prototyp programu do weryfikacji (aplikację o nazwie ProvenView), czy podczas rozmowy przez kamerę mamy do czynienia z prawdziwą osobą, a nie deepfake’iem. Wykorzystuje ono zero-knowledge proof (ZKP) – technikę kryptograficzną, która pozwala na udowodnienie prawdziwości pewnej informacji bez ujawniania szczegółów. Obecnie aplikacja jest na etapie testowym, trzymamy kciuki za jej powodzenie.

DR AGNIESZKA BUTOR-KELER, adiunkt w Zakładzie Cyfrowych Finansów FINTECH, Instytut Finansów Korporacji i Inwestycji, Kolegium Nauk o Przedsiębiorstwie SGH

MONIKA SZPIGANOWICZ, radca prawny, ekspert w zakresie Governance, Risk and Compliance (GRC) oraz nowych technologii

Wykładowczynie prowadzonych w SGH studiów podyplomowych Fintech – nowe zjawiska i technologie na rynku finansowym.

1 https://www.linkedin.com/posts/rafa%C5%82-brzoska-6a360334_stopdeepfake…